随着人工智能技术的快速发展,许多朋友可能已经上过AI课程,甚至购买了网上提示词合集。然而,你是否还在用那些传统的提示词写作方式?比如在提示词中一步步拆解思维链,帮助模型学会分步思考;提供几个例题以加深模型对问题的理解;或者引导模型扮演特定角色,从而给出更专业的答案。这些技巧虽然在过去非常有效,但如今可能已经不再适用。

实际上,在不知不觉中,大模型已经逐渐分化为两大类:传统通用大模型和推理大模型。例如,GPT-o1并不是GPT-4o的直接升级版本。GPT-4o属于通用大模型,而GPT-o1则是一款推理模型。类似地,DeepSeek默认使用的V3版本是通用大模型,而点击左下角“深度思考”按钮时,系统会切换到R1推理模型。在推理模型的时代,过于详细的提示词可能会适得其反,导致AI表现下降。

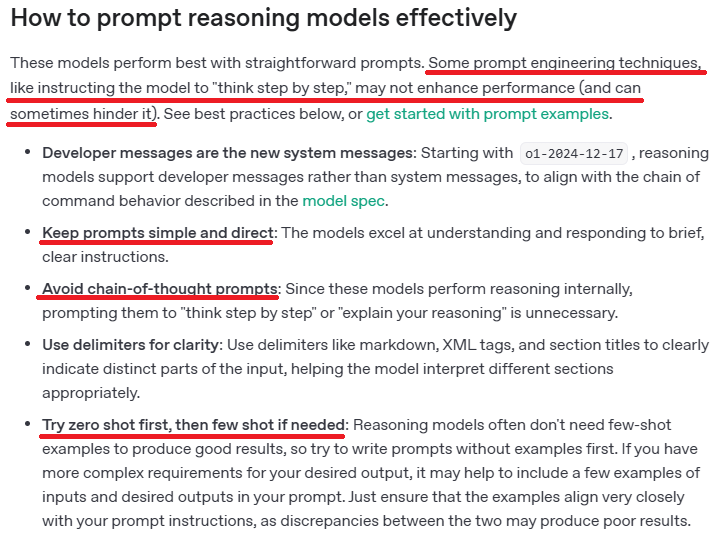

根据OpenAI的官方文档,推理模型专栏明确指出,使用过于精确或引导思考型的提示词反而会降低回答效果。他们建议用户尽量减少使用思维链提问,直接提出问题即可。如果效果不佳,可以再提供具体示例供AI学习。此外,DeepSeek-R1的技术报告也提到,“DeepSeek-R1对提示词非常敏感,举例反而可能降低模型表现”。因此,为了获得更好的效果,建议用户直接描述问题,而不必举例子。

不仅是GPT和DeepSeek,Claude 3.7 Sonnet也在其官方文档中表示,相比于详细列出每一步操作的提示词,他们更希望用户直接明确需求。总结来说,与以往“提示词越详细,AI效果越好”的刻板印象不同,目前各大厂商对其推理大模型的共同建议是:直接、简洁、描述准确。

我们还进行了一项实验,从LeetCode中挑选了几十道难度较高的题目,并在ChatGPT上进行了测试。按照传统方法,我们编写了一段提示词,包括暗示它成为一名程序员、要求进行思维链思考,并提供了大量示例。结果发现,对于大部分题目,无论提示词长短,推理模型o1都能给出正确代码,且表现相当出色,击败了70%以上的用户。然而,在某些特定题目(如1147、471、458、1735、1799)中,o1在传统提示词下失败了,甚至有一题直接卡死。但当我们去掉角色扮演、示例和思维链引导后,o1在相同问题上成功给出了正确答案。

那么,为什么曾经有效的提示词在推理模型时代变得不再适用呢?主要原因在于传统非推理模型和推理模型的思维方式发生了变化。传统大模型通常采用无监督学习和监督微调,目标是根据提示词逐字猜出正确答案。这种模型能力虽强,但缺乏主见,因此用户的提示词越详细,越能引导模型按照预期行动。而推理模型则增加了基于强化学习的训练方法,使其具备更强的推理能力和自主判断力。如果继续用详细步骤指导模型,可能会与其自身的推理逻辑产生冲突。

通过实验我们发现,用传统提示词让o1解决数学相关的编程题目时,翻车概率显著增加。这可能是因为提示词仅让模型成为“资深程序员”,而非“擅长数学的程序员”。此外,各大模型的官方文档普遍建议用户简化提示词,避免复杂设计,同时明确最终目标和结果格式。适当使用符号划分问题结构也能提升效果。总之,尊重AI的操作方式,清晰表达需求,可能是最高效的方法。

随着大模型能力的不断提升,写提示词的门槛将逐渐降低。但提示词工程是否会完全消失?我们请教了李继刚老师,他曾创作出“汉语新解”等神级提示词。他认为,只要不同的输入仍能带来不同的输出,提示词工程就会一直存在。因此,作为用户,我们应该与时俱进,更新提示词策略,避免固守过时的方法。

本文来源: iFeng科技【阅读原文】

iFeng科技【阅读原文】