在催化剂筛选领域,快速评估催化剂表面与吸附质之间的全局最低吸附能(Global Minimum Adsorption Energy, GMAE)是至关重要的任务。然而,传统基于密度泛函理论(DFT)的计算方法往往需要处理多个吸附位点和复杂构型,导致时间和资源成本高昂。

为解决这一问题,洛桑联邦理工学院(EPFL)Philippe Schwaller教授团队与上海交通大学贺玉莲教授团队联合开发了一种多模态Transformer框架——AdsMT。该框架由博士生陈俊武(现就读于EPFL)和黄旭(现就读于UC Berkeley)共同主导完成,并于2025年4月4日发表在《Nature Communications》上,标题为「A multi-modal transformer for predicting global minimum adsorption energy」。

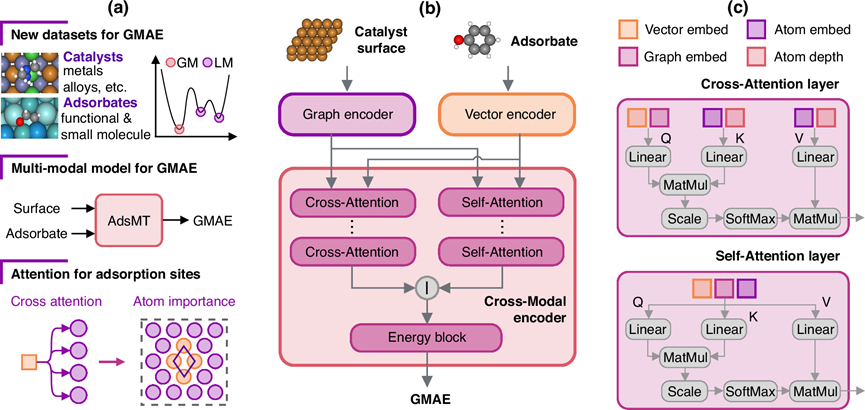

AdsMT模型架构

AdsMT框架由三个核心模块组成:图编码器用于捕捉催化剂表面的结构信息,向量编码器用于提取吸附质特征,跨模态编码器则通过跨注意力(cross-attention)和自注意力(self-attention)机制整合两种模态的信息。具体而言,跨注意力层将吸附质向量与表面图结构拼接成查询矩阵(Q),而键(K)和值(V)矩阵则由原子嵌入和深度嵌入构成。深度嵌入帮助模型理解原子在表面结构中的相对位置(如顶层或底层)。随后,自注意力层进一步整合这些信息,生成统一的多模态表征,用于最终的GMAE预测。

GMAE基准数据集

为了系统评估模型的性能,研究团队构建了三个具有代表性的基准数据集:OCD-GMAE、Alloy-GMAE和FG-GMAE。这些数据集涵盖了不同的催化剂表面与吸附质组合,为AdsMT及其他相关研究提供了可靠的评测基础。

AdsMT模型表现及迁移学习

AdsMT结合定制化图神经网络Transformer编码器(AdsGT)和迁移学习策略,展现出卓越的预测能力。实验结果显示,在Alloy-GMAE数据集上,AdsMT的平均绝对误差(MAE)为0.143 eV,成功率(Success Rate, SR)达到66.3%;在FG-GMAE数据集中,MAE低至0.095 eV,SR高达71.9%。此外,针对数据稀缺场景(如OCD-GMAE数据集),团队引入了迁移学习策略,利用包含局部最低吸附能(LMAE)的大规模数据集OC20-LMAE进行预训练,显著提升了模型性能。

模型可解释性与不确定性量化

AdsMT不仅能够高效预测GMAE,还能通过分析跨注意力层的注意力分数识别最优吸附位点,且无需任何显式的吸附位点信息。此外,研究团队通过训练多个独立的AdsMT模型副本,成功实现了不确定性量化评估。结果表明,AdsMT的不确定性估计与预测误差高度相关,尤其在低不确定性区间表现出极高的准确度。

总结与展望

AdsMT是一种通用的多模态Transformer框架,能够在不依赖具体吸附位点信息的情况下直接预测表面-吸附质体系的GMAE。其高效的预测能力和良好的泛化性能使其适用于大规模催化剂虚拟筛选。未来,团队计划结合机器学习势函数(MLIP)和主动学习策略进一步提升模型性能,并探索将吸附构型等知识融入训练过程的可能性。

机器之心【阅读原文】

机器之心【阅读原文】