南大和旷视研究院的专家们开发了一种创新的无监督范式,名为Self-Supervised Visual Preference Alignment(SeVa),旨在降低视觉大模型的偏好对齐成本。研究团队发现现有的视觉大模型在用户体验方面存在不足,如不遵循指令、产生误导性回答等问题。为了解决这些问题,他们提出了一套自动化构建偏好数据的方法,无需GPT-4或人工打标签。

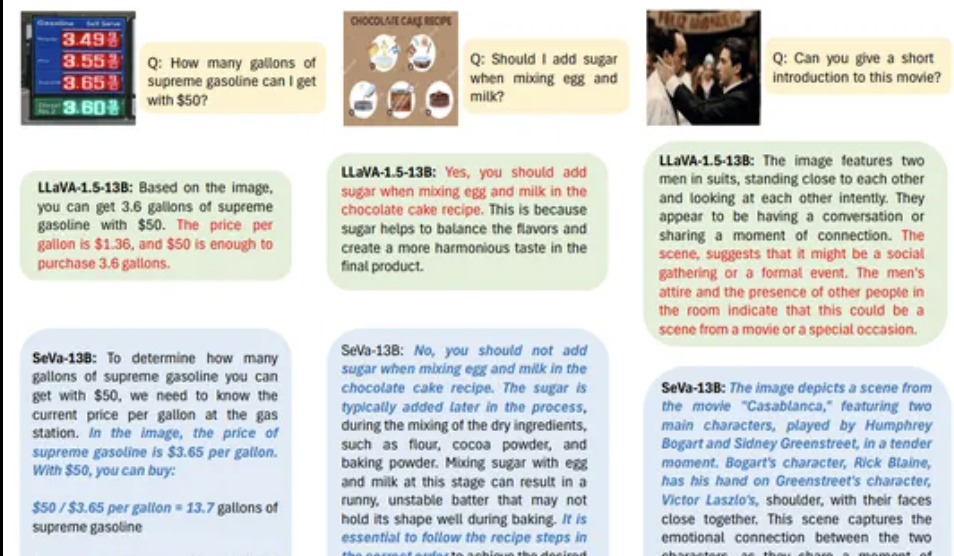

SeVa通过构造正负样本对比数据集,利用LLaVa-1.5模型的图像增广技术,生成正样本(原始图像的回答)和负样本(增广图像的回答)。这种方法提高了模型的指令遵循能力和用户友好性,减少了幻觉回答,并在多模态基准测试中展现出显著提升。实验结果显示,仅使用8k无监督数据就能带来明显的改进。

此外,SeVa的DPO训练中,偏好分布与对比损失之间的关系被详细探讨,表明可以通过对比学习思路增强DPO,提升模型性能。SeVa在多个benchmark上的表现稳定,尤其在MMVet和LLaVA-bench上的提升显著,同时在POPE和SHR指标上也表现出更好的性能。与SFT相比,SeVa在微调VLM时更具优势,包括更快的训练时间、更少的数据需求和无需监督的pipeline。

SeVa的输出不仅更接近问题,而且一致性更强,对不同扰动具有更高的鲁棒性。通过可视化分析,SeVa的输出质量优于未经DPO训练的LLaVA,提供更长、更详细的回答,更好地符合人类偏好。

本文来源: 量子位【阅读原文】

量子位【阅读原文】 © 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...