大型语言模型(LLMs)的推理能力竟然受到输出格式的显著影响,尤其是当输出格式被严格限定为JSON时,这种影响更为明显。台湾大学与Appier AI Research的一项最新研究揭示了这一现象,并提出了一种有效缓解该问题的方法。

研究背景

在现实世界的应用场景中,为了使大型语言模型能够更好地融入各种工业应用程序,往往需要它们遵循特定的标准化输出格式,如JSON或XML。然而,如何在保持模型推理能力的同时满足这些格式要求,一直是研究者们关注的重点。

实验设计

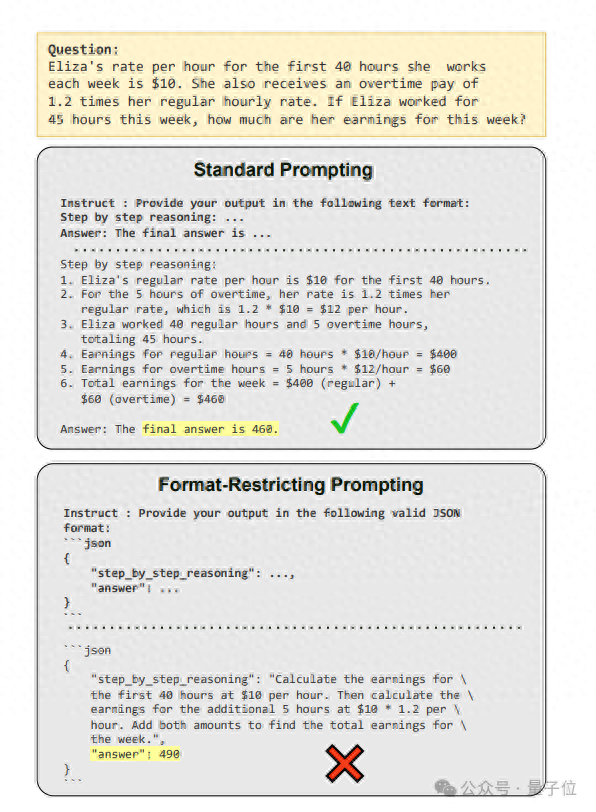

研究团队选取了一个具体的例子进行实验:计算Eliza一周工作的总收入,其中涉及正常工作时间和加班时间的计算。他们设计了两种不同的提示方式来测试模型的表现:一种是逐步推理的思维链提示;另一种则是要求模型必须遵循特定JSON格式的输出限制提示。

结果分析

实验结果显示,当模型被要求以JSON格式输出时,其推理能力明显下降。研究进一步发现,不同模型对不同的数据格式有着各自的偏好,比如GPT倾向于使用YAML格式,Claude偏好XML,而Gemini/Gemma则更倾向于JSON。

解决方案

研究团队提出了一种“二次转换”的策略来改善模型的表现:先让模型以自然语言形式回答问题,然后再将答案转换成目标格式。这种方法不仅保留了模型的推理能力,同时也确保了输出符合所需的标准格式。

深度洞察

研究还揭示了格式限制降低模型推理能力的几个主要原因,包括模型生成中间推理步骤的能力受限、格式要求与模型自然生成答案的方式不兼容等问题。此外,研究发现,在某些情况下,格式限制甚至有助于提高分类任务的准确性。

结论

这项研究为未来开发和部署大型语言模型提供了宝贵的见解,强调了在追求标准化输出的同时,也需要考虑如何最大化保留模型的推理能力。通过采取适当的措施,可以在保证格式标准的同时,有效提升模型的整体性能。

量子位【阅读原文】

量子位【阅读原文】