11月4日,Anthropic 发布了一篇博文,宣布开发者可以通过第一方API、Amazon Bedrock 和 Google Cloud 的 Vertex AI 调用最新的 Claude 3.5 Haiku 模型。这款新模型在多个 AI 基准测试中超越了 Anthropic 上一代的最大模型 Claude 3 Opus,并且主要对标 OpenAI 的 GPT-4 Mini 和谷歌的 Gemini 1.5 Flash。

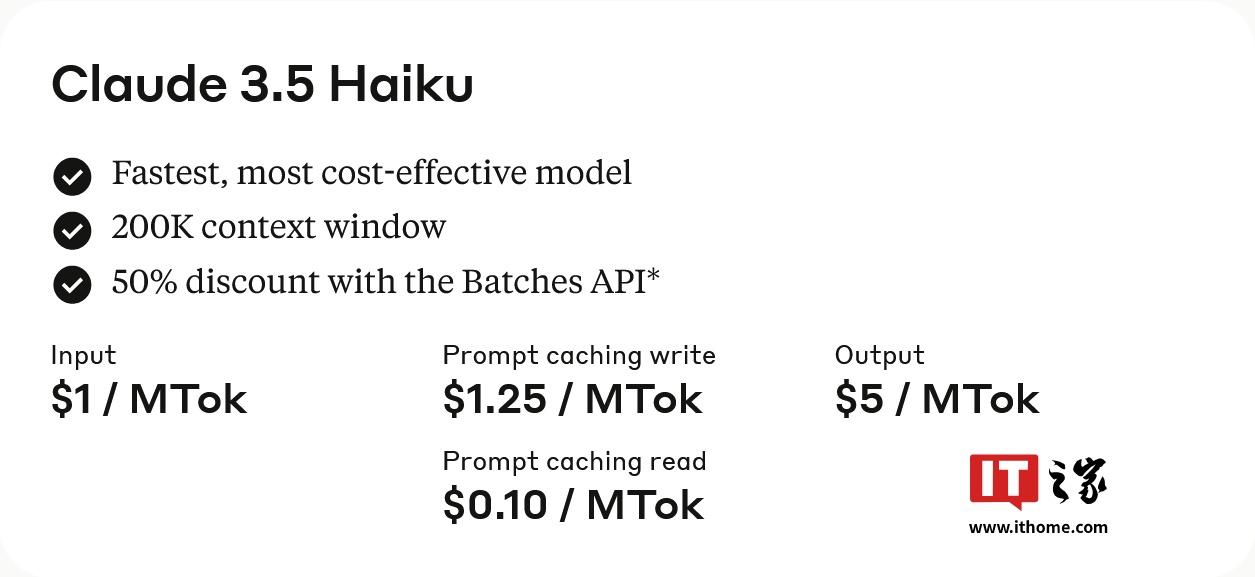

Claude 3.5 Haiku 目前仅支持文本模态,但未来将扩展到图像输入。最让开发者惊喜的是其定价策略:每百万 tokens 输入售价为 1 美元,每百万 tokens 输出售价为 5 美元。通过提示词缓存可以节省最多 90% 的成本,而使用 Message Batches API 则可以节省 50% 的成本。

相比之下,OpenAI 的 GPT-4 Mini 模型的定价为每百万 tokens 输入 0.15 美元,每百万 tokens 输出 0.6 美元(约合 4.3 元人民币)。谷歌的 Gemini 1.5 Flash 模型在提示词少于 12.8 万个 token 时,每百万 tokens 输入售价为 0.075 美元,每百万 tokens 输出售价为 0.3 美元;当提示词超过 12.8 万个 token 时,每百万 tokens 输入售价为 0.15 美元,每百万 tokens 输出售价为 0.6 美元。

本文来源: IT之家【阅读原文】

IT之家【阅读原文】 © 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...