11月11日,字节跳动在豆包大模型团队官网上发布了最新的通用图像编辑模型——SeedEdit。这款模型支持用户通过简单的自然语言指令轻松修改图片,包括修图、换装、美化、风格转换、在指定区域添加或删除元素等多种编辑操作。目前,SeedEdit已在豆包PC端和即梦网页端开始测试。用户在豆包生成图片后,只需点击“继续编辑”按钮,输入简单的文本指令,即可轻松调整图片背景或主体,实现一句话改图。

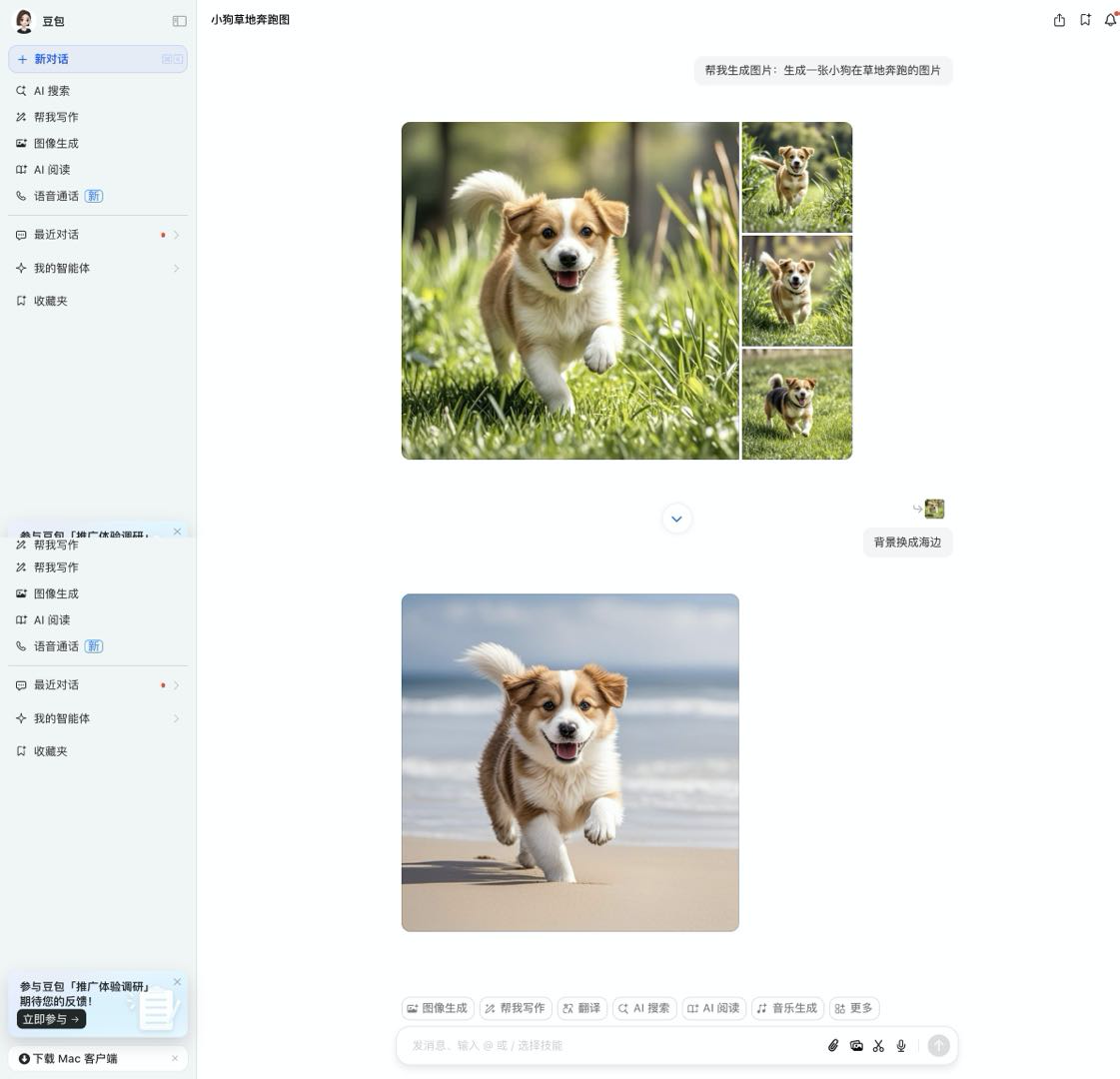

例如,用户可以生成一张“小狗在草地奔跑”的图片,然后直接输入“背景换成海边”等指令,获得一张基于原图的微调图。此外,用户还可以在豆包PC端或即梦的图像生成功能中上传参考图并进行二次加工。SeedEdit是国内首款实现产品化的通用图像编辑模型。尽管学术界在文生图和图生图领域已有较多研究,但生成图片的指令编辑一直是一个难题,二次修改很难保证稳定性和生成质量。

今年以来,Dalle3和Midjourney相继推出了产品化的图像编辑功能,相比之前的方案,编辑生成图片的质量有了显著提升,但在用户编辑指令的精准响应和原图信息保持方面仍有所欠缺。字节跳动豆包大模型团队表示,图像编辑任务的关键在于在“维持原始图像”和“生成新图像”之间找到最佳平衡点,这一理念贯穿了整个模型的设计与优化过程。

在模型数据生产过程中,SeedEdit针对数据稀缺问题,重新设计了模型架构,并采用了多模型、多尺度和多标准的数据制造方案,有效解决了数据量、多样性和质量问题。作为一款专为图像编辑任务设计的模型,SeedEdit在通用性、可控性和高质量方面取得了显著突破。此前,业界技术主要针对单个专家任务进行优化,例如表情、发型、背景的删除或替换,或专门配置工作流进行风格调配,每次出现新的编辑任务都需要收集对应数据进行训练开发。

而SeedEdit作为通用的图像编辑模型,适用于各种编辑任务,支持用户发挥创意,无需再进行微调即可快速应用。与业界同类方法(如EMU Edit和Ultra Edit)相比,SeedEdit在性能指标上表现更为优秀。HQ-Edit等基准测评显示,SeedEdit能够理解相对模糊的指令,并在执行细致编辑时具有更高的图像保持率和成功率。即使在常规任务中,如“抠图”换背景等用户最常用的图像分割任务中,SeedEdit生成的图像风格自然,无“贴图感”。

在局部涂抹、编辑、添加和删除元素等任务中,SeedEdit通过语言指定,大大节省了用户手动涂抹的时间,特别是在处理裂纹、发丝等精细区域时。通过创新的模型架构和多尺度、多规则的数据获取、构造和过滤方案,SeedEdit能够更好地理解用户意图,并与扩散生成模型对齐,极大提高了图像编辑的精准度,同时保持了高质量的图片生成效果。

基于豆包文生图大模型,SeedEdit目前支持中文和英文输入,还可以对中文成语和专有名词进行精准响应。下一步,SeedEdit将开放多轮复杂编辑的功能。豆包大模型团队表示,现阶段SeedEdit对模型生成图片的编辑效果要优于输入真实图片,但在更复杂和更精细的控制上仍有改进空间。未来,SeedEdit将在真实图片保真、ID保持、编辑精确性以及长时序的故事类、漫画类生成方面进行进一步优化和探索,提升编辑可用率和用户体验,支持用户更高效地创作有趣的。

本文来源: 机器之心【阅读原文】

机器之心【阅读原文】