北京交通大学的研究团队最近低调发布了一个名为 O1-CODER 的新项目,该项目专注于编码任务,并且所有源代码、精选数据集及衍生模型均已完全开源。研究团队认为,编码是一项需要深思熟虑、逻辑严谨、逐步解决问题的典型任务,属于 System-2 思维方式。为了提升模型的 System-2 能力,他们创新地将强化学习(RL)与蒙特卡洛树搜索(MCTS)相结合,使模型能够自动生成推理数据,从而不断提升其逻辑推理能力。

在实验中,研究团队得出了几个关键结论:

– 当推理正确时,基于伪代码的推理显著提高了代码生成的质量。

– 将监督微调(SFT)与直接偏好优化(DPO)相结合,可以有效提升测试用例的生成效果。

– 自我对弈强化学习为推理和代码生成提供了一个持续改进的循环机制。

具体而言,团队通过测试用例生成器在 DPO 后达到了 89.2% 的通过率,相较于初始微调后的 80.8% 显著提升;Qwen2.5-Coder-7B 通过伪代码方法实现了 74.9% 的平均采样通过率,提升了 25.6%。这些成果得到了广大网友的高度认可,纷纷表示非常需要这样的模型。

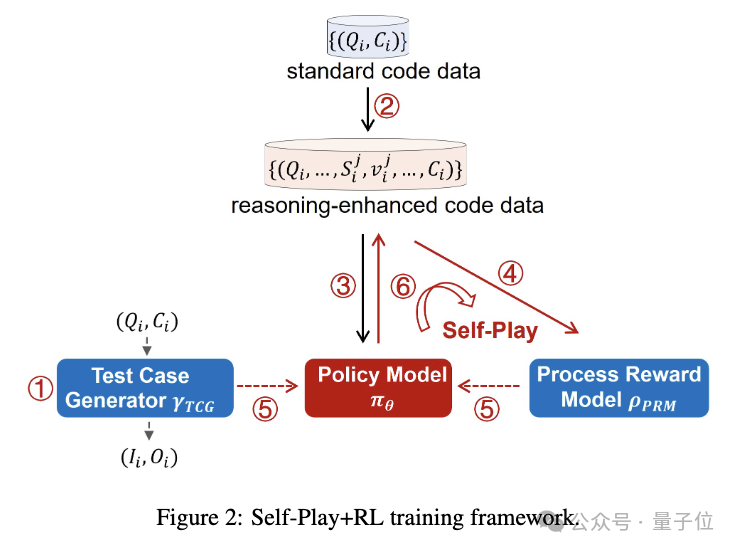

O1-CODER 的设计思路主要分为六个步骤,逐步优化模型的代码生成能力:

1. 训练测试用例生成器(TCG),为代码测试提供标准化的环境。

2. 利用 MCTS 生成包含推理过程的代码数据。

3. 迭代微调策略模型,先生成伪代码,再生成完整代码。

4. 基于推理过程数据初始化过程奖励模型(PRM)。

5. 在 TCG 提供的结果奖励和 PRM 提供的过程奖励的双重引导下,通过强化学习和 MCTS 更新策略模型。

6. 利用优化后的策略模型生成新的推理数据,返回第 4 步继续迭代训练。

在应用自我对弈强化学习的过程中,团队面临了两大挑战:一是如何评估生成代码的质量,二是如何定义思考和搜索行为。为了解决这些问题,团队提出了以下解决方案:

– 结果评估:训练一个测试用例生成器(TCG),根据问题和标准代码自动生成测试用例,为强化学习提供标准化的代码测试环境和结果奖励。

– 定义思考和搜索行为:采用“先思考后行动”的方式,先通过详细的伪代码思考问题,再基于伪代码生成最终的可执行代码。这种方式不仅具有较高的适应性,还能通过调整伪代码的细节程度来控制推理/搜索行为的粒度。

在实验部分,研究人员详细介绍了测试用例生成器的训练过程,分为两个阶段:

1. 监督微调(SFT):确保生成器的输出符合预定义格式,以便准确解析和提取生成的测试用例。训练数据来自 TACO 数据集。

2. 直接偏好优化(DPO):引导模型生成符合特定偏好的测试用例,进一步提高生成器的性能和可靠性。实验表明,SFT 阶段过后,TCG 在标准代码上生成的测试用例通过率达到 80.8%,DPO 阶段进一步提升至 89.2%,显著提高了生成器生成可靠测试用例的能力。

此外,研究者还引入了基于伪代码的提示方法,作为引导模型进行深度推理的“认知工具”。他们定义了三个关键行为:

– 使用伪代码定义算法结构,勾勒主要函数的结构和接口,把握任务的整体框架。

– 细化伪代码,逐步明确每个函数的具体步骤、逻辑和操作。

– 从伪代码生成代码,将伪代码的结构和逻辑精准翻译为可执行代码。

在 MBPP 数据集上的初步实验显示,尽管整体通过率(Pass@1)有所下降,但 Average Sampling Pass Rate(ASPR)显著提高,表明结合伪代码显著改善了推理过程的质量,尤其是在细化通向正确输出的路径方面。这为后续的自监督微调和强化学习提供了良好的起点。

在自我对弈 + 强化学习的研究中,团队详细描述了如何使用蒙特卡洛树搜索(MCTS)来构建步骤级别的过程奖励数据。这一过程涉及为每个问题形成一个推理路径,该路径由一系列推理步骤组成,并最终产生一个可执行的代码。在 MCTS 的路径探索中,使用伪代码提示策略来引导推理过程。当达到终端节点时,形成一个完整的伪代码推理路径。终端节点的奖励值基于编译成功率(compile)和测试用例通过率(pass)两个关键指标计算,并反向传播到路径上的所有前序节点,为每个步骤分配一个奖励值。通过这种方式,构建了推理过程数据集,为策略模型的初始化和训练提供了基础。

过程奖励模型(PRM)的任务是为当前步骤分配一个奖励值,以估计其对最终答案的贡献。在数据合成过程中使用的树搜索方法可以组织成点式(point-wise)和成对式(pair-wise)两种数据格式。基于这些经过验证的正确推理解,策略模型得到初始化。接下来,PRM 开始评估每一步推理对最终答案的贡献。在 TCG 提供的结果奖励和 PRM 提供的过程奖励的双重引导下,策略模型通过强化学习不断改进。更新后的策略模型被用来生成新的推理数据,补充到现有数据集中,形成自我对弈的闭环。这一数据生成-奖励建模-策略优化的迭代循环,确保了系统推理能力的持续提升。

本文来源: IT之家【阅读原文】

IT之家【阅读原文】