期待2025年AI领域的新突破:从推理到空间智能

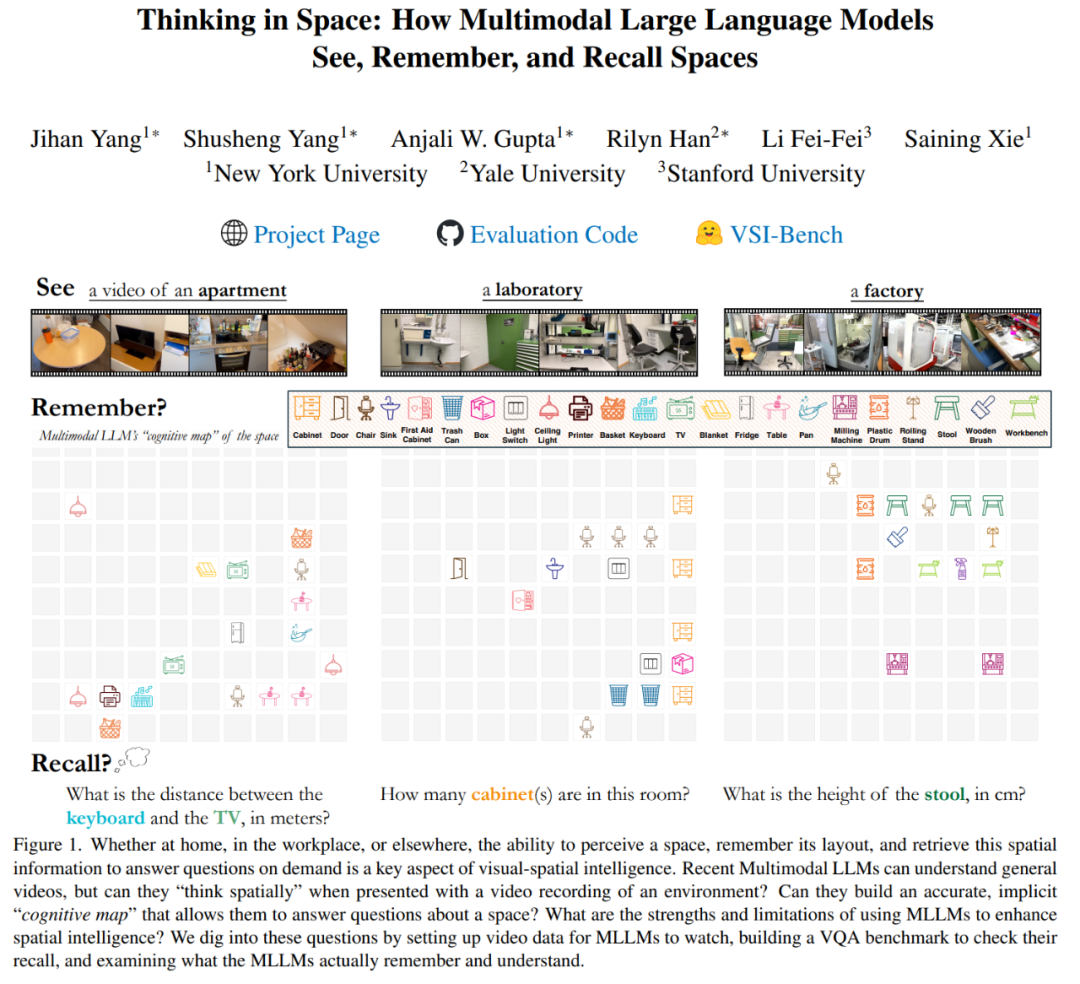

随着技术的不断进步,我们对人工智能(AI)的期望也在不断提升。展望2025年,AI领域不仅要在推理能力上取得进展,更需要在视觉空间智能方面实现新的突破。人类凭借视觉空间智能(visual-spatial intelligence),能够通过连续的视觉观察记住并理解复杂的空间环境。然而,多模态大语言模型(MLLM)是否也能具备这种能力呢?

为了探索这一问题,来自纽约大学、耶鲁大学和斯坦福大学的研究团队引入了VSI-Bench,这是一个基于视频的基准测试工具,旨在评估MLLM在视觉空间智能方面的表现。VSI-Bench涵盖了近290个真实室内场景视频,包含超过5000个问答对,这些数据集不仅丰富了空间理解和推理的能力,还模拟了人类观察世界的方式。

VSI-Bench:评估多模态大语言模型的空间思维能力

VSI-Bench的任务包括物体计数、相对距离估计、出现顺序判断、相对方向识别、物体大小测量、绝对距离估计、房间面积计算和路径规划等。通过对15个支持视频的MLLM进行评估,研究者发现尽管MLLM在某些任务上表现出色,但与人类相比仍有明显差距。例如,在配置和时空任务上,MLLM的表现接近完美;但在需要精确测量的任务中,仍存在较大差异。

空间智能的挑战与机遇

李飞飞教授及其团队指出,空间推理是影响MLLM性能的关键瓶颈。虽然语言提示技术在其他任务中有效,但在空间推理中却可能带来负面影响。此外,MLLM在记忆空间时会形成一系列局部世界模型,而非统一的全局模型。这表明,未来的AI助手在日常空间导航和经验处理方面还有很大的改进空间。

实验结果与未来展望

实验结果显示,Gemini-1.5 Pro是表现最佳的专有模型,尽管其训练数据仅限于2D数字,但在某些任务上的表现接近人类水平。开源模型如LLaVA-NeXT-Video-72B和LLaVA-OneVision-72B也取得了不错的成绩,但仍需进一步优化以缩小与人类的差距。

总的来说,这项研究表明,尽管MLLM在空间推理方面已经展现出一定的潜力,但要真正实现类人级别的视觉空间智能,仍有许多挑战需要克服。随着更多研究的深入和技术的进步,2025年的AI领域有望迎来更多令人振奋的突破。

本文来源: 机器之心【阅读原文】

机器之心【阅读原文】