Deepseek-v3开源LLM新模型意外曝光!编程跑分在LiveBench上一举超越Claude 3.5 Sonnet,MoE架构助力性能飞跃

Deepseek新模型意外曝光,编程跑分超越Claude 3.5 Sonnet,登顶LiveBench最强开源LLM宝座

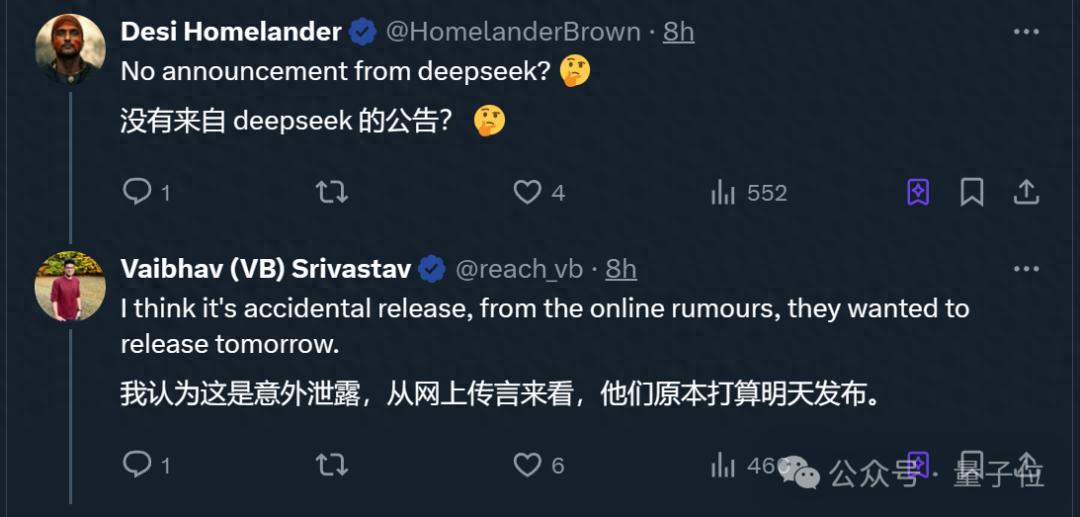

近日,Deepseek-v3在未正式宣布的情况下意外曝光,并迅速引发广泛关注。据Reddit网友爆料,Deepseek-v3已在API和网页上发布,多个评测榜单也相继出炉。

在Aider多语言编程测试排行榜中,Deepseek-v3一举超越了Claude 3.5 Sonnet,紧随o1之后位列第二,完成率从v2.5的17.8%大幅提升至48.4%。同时,在LiveBench测评中,Deepseek-v3成为当前最强的开源大语言模型(LLM),在非推理模型中仅次于gemini-exp-1206,排名第二。

目前,Hugging Face平台上已上线Deepseek-v3(Base)的开源权重,但尚未上传模型介绍卡片。综合多方爆料,Deepseek-v3相比前代v2和v2.5有了显著提升。

Deepseek-v3的技术亮点与改进

Deepseek-v3采用685B参数的MoE架构,包含256个专家,使用sigmoid函数作为路由方式,每次选取前8个专家(Top-k=8)。它支持64K上下文,默认支持4K,最长支持8K上下文,处理速度约为60个tokens/s。

机器学习爱好者Vaibhav Srivastav(简称瓦哥)深入研究了配置文件,并总结出v3与v2、v2.5的关键区别:

1. 门控函数的变化:v3使用sigmoid作为门控函数,取代了v2中的softmax函数。这使得模型能够在更大的专家集合上进行选择,而不像softmax倾向于将输入分配给少数几个专家。

2. 新的Top-k选择方法:v3引入了noaux_tc方法,无需辅助损失即可有效选择Top-k个专家。这一改进简化了训练过程并提高了效率。

3. 新增参数e_score_correction_bias:用于调整专家评分,从而在专家选择或模型训练过程中获得更好的性能。

此外,v3在配置上超越了v2.5,包括更多的专家数量、更大的中间层尺寸以及每个token的专家数量。

网友实测Deepseek-v3

独立开发者Simon Willison(Web开发框架Django的创始人之一)对Deepseek-v3进行了实际测试。他发现Deepseek-v3基于OpenAI的GPT-4架构,并展示了其图像生成能力,生成了一张鹈鹕骑自行车的SVG图。

另一网友在测试中发现,Deepseek-v3有时会回答自己来自OpenAI,推测可能是因为在训练时使用了OpenAI模型的回复。

尽管还未正式官宣,Deepseek-v3已在LiveBench坐上最强开源LLM宝座,赢得了众多网友的好评,被认为比只搞期货的OpenAI更具优势。

本文来源: 量子位【阅读原文】

量子位【阅读原文】