ChatGPT 引发的 AI 安全新挑战

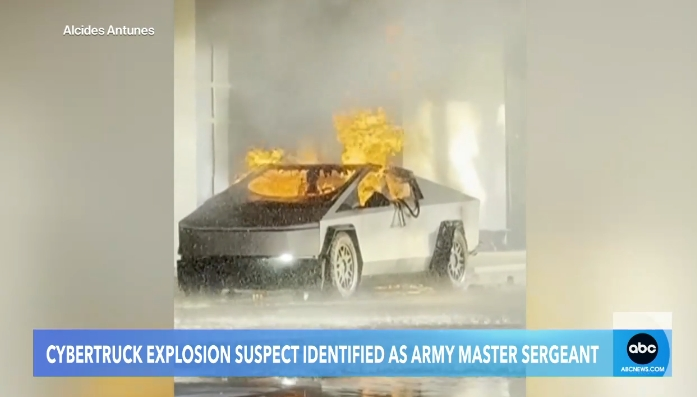

新年伊始,ChatGPT 成为了「恐怖分子」的帮凶?据报道,一名美国现役军人通过 ChatGPT 获取爆炸知识,并成功引爆了一辆特斯拉 Cybertruck。这一事件并非科幻电影桥段,而是 AI 安全风险在现实中上演的真实缩影。知名投资人 Rob Toews 在《福布斯》专栏预测,2025 年将迎来「第一起真实的 AI 安全事件」。AI 已经成为我们生活中的一部分,它既强大又难以驾驭,且具有欺骗性。

行业预测与安全趋势

北京智源研究院发布的 2025 十大 AI 技术趋势报告指出,AI 安全作为一个独立的技术赛道被列为第十个趋势。报告强调,随着大模型能力的提升,风险预防和治理体系也需同步完善。复杂系统特有的涌现结果不可预测、循环反馈等特性对传统工程的安全防护机制带来了挑战。如何引入新的技术监管方法,在人工监管上平衡行业发展和风险管控,是各方需要持续探讨的议题。

AI 大模型的安全挑战

2024 年,AI 大模型实现了跨越式发展,但也暴露出许多安全问题。根据研究,AI 安全风险可以分为三类:内生安全问题、衍生安全问题和外生安全问题。「内生安全问题」如数据有毒、价值对齐、决策黑盒等问题,源于大模型庞大的架构和复杂的内部交互机制。例如,ChatGPT 的复读漏洞可能导致隐私泄露,而 Prompt 攻击则让攻击者能绕过安全限制生成违禁。

衍生安全问题与社会影响

AI 滥用引发的其他领域重大安全事故,如假新闻、深度伪造诈骗、侵犯知识产权等,对社会治理提出了重大挑战。西藏日喀则地震期间,一张由 AI 生成的图片被误认为真实新闻,引发了广泛关注。此外,深度伪造还将网络性暴力推向极端,版权问题也成为 AI 发展的一大障碍。OpenAI 等公司深陷版权泥潭,爱奇艺起诉某大模型公司魔改经典影视剧片段,开创了国内 AI 视频侵权诉讼先例。

外生安全问题与数据保护

外生安全问题主要涉及外部网络攻击,如平台、框架安全漏洞、模型被盗、数据泄露等。AI 模型推理通常在明文状态下进行,用户输入大量敏感数据,获取模型建议。2024 年,企业员工上传到生成式 AI 工具的敏感数据增长了 485%,包括客户支持信息、源代码和研发数据。多模态大模型的发展使数据的安全防护变得更加复杂。

构筑多维安全航道

面对这些挑战,整个业界、政府和国际组织在 AI 治理方面做了很多工作。中国在大模型应用与治理方面走在了世界前列,相继发布了多项规范和标准。北京智源研究院研发了防御大模型和 AI 监管大模型,创新了对齐优化方法。蚂蚁集团推出的「蚁天鉴」平台具备检测与防御双重核心安全技术能力。华为、360 集团等厂商也在积极探索 AI 对抗 AI 的解决方案。

国际合作与行业协作

联合国科技大会发布了两项大模型安全标准,蚂蚁集团牵头制定了《大语言模型安全测试方法》,提供了可衡量的安全评估标准。北京智源研究院发起并承办了首个 AI 安全国际对话高端闭门论坛,签署了《北京 AI 安全国际共识》。欧盟建立了四级风险分类体系,明确了人工智能产品的全生命周期监管要求。主要头部 AI 公司也相继发布安全框架,寻求技术创新与社会责任的平衡。

结语

AI 越强大,安全科技的价值也在同步放大。唯有为其打造足够安全的刀鞘,才能让 AI 在造福人类的同时始终处于可控轨道。变与不变中,AI 安全治理或许才是 AI 行业永恒的话题。

机器之心【阅读原文】

机器之心【阅读原文】