机器之心学术专栏介绍

机器之心AIxiv专栏专注于发布前沿的学术和技术,过去几年中已报道了超过2000篇来自全球顶尖高校和企业的研究成果,有效促进了学术交流。如果您有优秀的科研成果或技术分享,欢迎通过以下邮箱投稿:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com。

YOLOv12:引入注意力机制的实时目标检测器

由纽约州立大学布法罗分校的田运杰、David Doermann以及中国科学院大学的叶齐祥合作完成的研究,提出了一种全新的YOLOv12模型。该模型在保持YOLO系列实时性的同时,成功将注意力机制(Attention Mechanism)融入其中,显著提升了性能。

解决注意力机制低效问题

传统的注意力机制由于计算复杂度高和内存访问效率低的问题,难以应用于对速度要求极高的YOLO系统。为此,作者提出了两种创新解决方案:

1. 区域注意力模块(Area Attention, A2):通过简单地将特征图划分为纵向或横向区域,降低了计算复杂度,同时保持了较大的感受野。

2. 残差高效层聚合网络(R-ELAN):引入了残差连接和缩放因子,优化了梯度流动,解决了大规模模型中的优化难题。

结构改进与优化

为了更好地适应实时目标检测任务,YOLOv12还进行了一系列结构改进:

– FlashAttention:解决了注意力机制的显存访问问题。

– 移除位置编码:简化模型设计,提升效率。

– 调整MLP Ratio:从4降至1.2或2,平衡计算资源分配。

– 减少堆叠块深度:简化优化过程,提高训练收敛性。

实验结果与分析

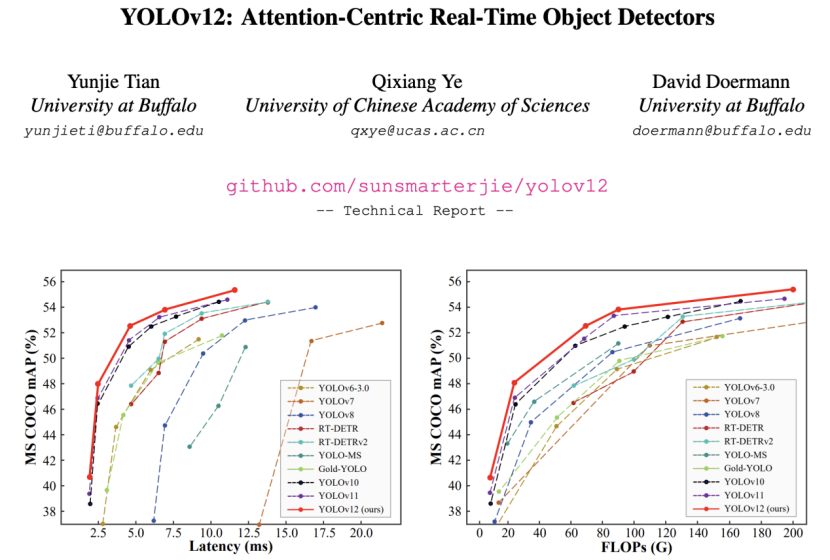

实验结果显示,YOLOv12在COCO数据集上取得了显著的性能提升,特别是在不同尺度的模型中表现优异。例如:

– N-scale 模型:比YOLOv6-3.0-N等版本提升3.6%至1.2%,推理速度达到1.64 ms/图像。

– S-scale 模型:在21.4G FLOPs和9.3M参数的情况下,实现48.0% mAP。

– M-scale 模型:在67.5G FLOPs和20.2M参数的情况下,实现52.5 mAP。

– L-scale 和 X-scale 模型:相比前代模型,在计算量、参数量和推理速度方面均有明显优势。

此外,可视化分析表明,YOLOv12生成的目标轮廓更清晰,前景激活更精确,这主要归功于区域注意力机制的引入,使其在捕捉全局上下文信息方面更具优势。

最后,作者期待YOLO社区能继续推动实时目标检测技术的发展,为更多应用场景提供支持。

本文来源: 机器之心【阅读原文】

机器之心【阅读原文】