阿里云在3月6日凌晨发布了最新的推理模型QwQ-32B。这款模型的参数量为320亿,虽然远低于DeepSeek-R1的6710亿参数,但在消费级显卡上也能实现本地部署,表现令人惊艳。特别是在数学推理和编程能力方面,QwQ-32B与DeepSeek-R1相当,甚至在通用能力测评中超越了后者。

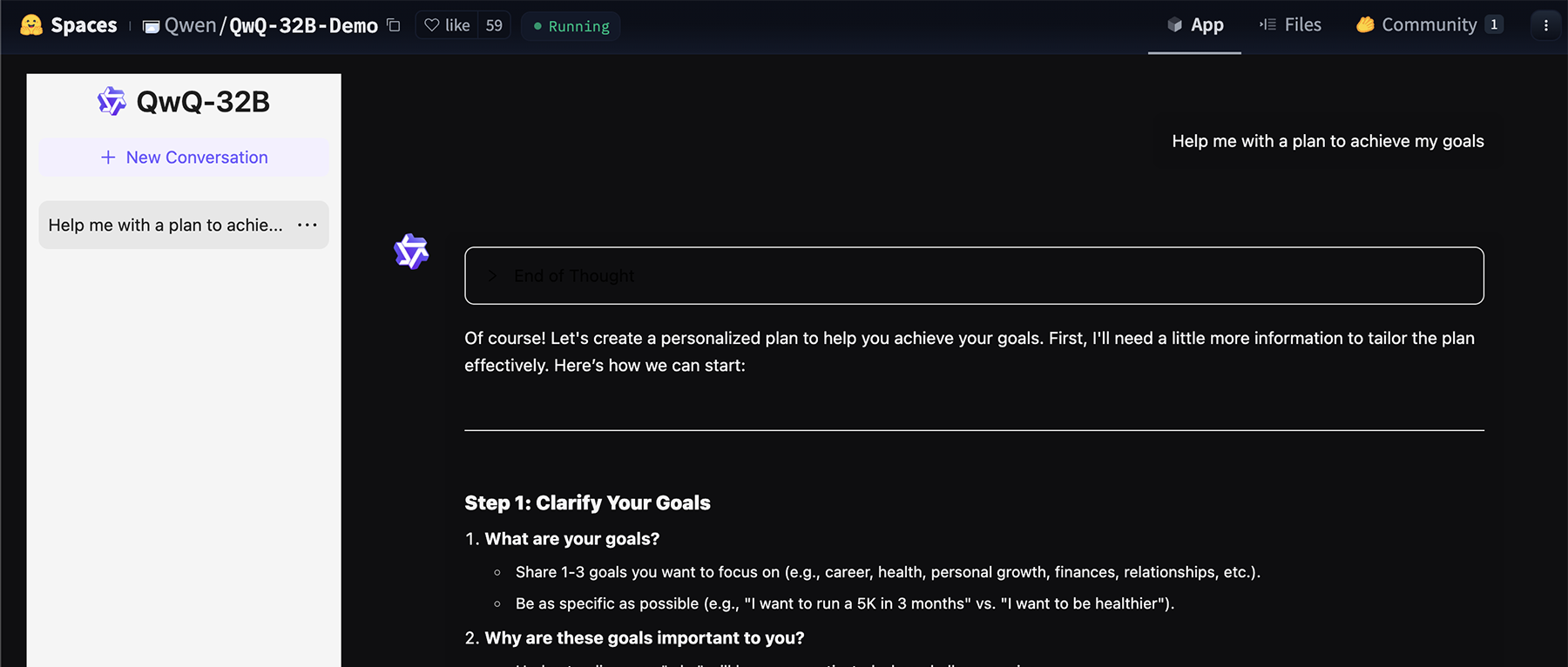

苹果机器学习科学家Awni Hannun(吴恩达的学生)展示了QwQ-32B在配备MLX框架的M4 Max芯片电脑上的运行速度,证实其“非常快”。该模型在Hugging Face和ModelScope上以Apache 2.0许可证开源,可用于商业和研究用途,为企业提供了强大的工具来增强产品和应用程序。

网友热议:QwQ-32B表现出色

社交平台上,网友们对QwQ-32B的表现赞不绝口。许多用户称赞其推理速度“非常快”,可与顶级模型相媲美。一些网友分享了在M4 Max芯片MacBook上的实际运行情况,证明其高效能。AI新闻发布者@Chubby称QwQ-32B“太疯狂了”,而Hyperbolic Labs的联合创始人Yuchen Jin则表示:“小模型太强大了!”

强化学习提升数学和编码能力

QwQ-32B通过大规模强化学习,在数学和编程任务上进行了特别训练。研究人员采用准确性验证器和代码执行服务器来提供反馈,确保生成的答案正确无误。随着训练轮次的推进,模型在这两个领域的性能持续提升。此外,QwQ-32B还使用通用奖励模型和基于规则的验证器进行训练,以改进指令遵循、人类对齐和代理推理。

模型架构和优化

QwQ-32B基于因果语言模型架构,包括64个Transformer层,具有RoPE、SwiGLU、RMS Norm和Attention QKV偏置等优化。它采用了分组查询注意力(GQA),扩展了上下文长度至131072个Tokens,允许更好地处理长序列输入。多阶段训练包括预训练、监督微调和RL,确保模型具备高性能和有效推理能力。

使用建议和未来展望

为了获得最佳性能,通义千问团队建议了一些设置,如强制正确输出、采样参数、标准化输出格式等。此外,该模型支持vLLM高吞吐量推理框架,但当前实现仅支持静态YaRN缩放。

研究人员将强化学习视为下一代AI模型的关键驱动力,计划进一步探索扩展RL以提高模型智能,并继续开发为RL优化的基础模型,推动向通用人工智能的发展。

本文来源: 智东西【阅读原文】

智东西【阅读原文】