谷歌Gemini大模型在AI编程领域全面屠榜,称霸大模型竞技场!SWE-bench verified认证,Humanitas Last Exam成绩超越OpenAI,免费体验最强推理模型

第一段

智东西(公众号:zhidxcom)

作者 | 陈骏达

编辑 | 心缘

智东西3月26日报道,谷歌正式推出了Gemini 2.5思考模型家族的首个成员——Gemini 2.5 Pro实验版本。这款模型在多项基准测试中全面超越了OpenAI o3-mini、Claude 3.7 Sonnet、Grok-3和DeepSeek-R1等竞争对手,并在大模型竞技场获得了1443分,以39分的优势稳居榜首。然而,谷歌并未公开Gemini 2.5 Pro与OpenAI o1、o1-Pro和o3等模型的对比数据。此外,在SWE-bench verified编程评估基准上,其得分略低于Claude 3.7 Sonnet。

第二段

Gemini 2.5 Pro不仅在衡量人类偏好的大模型竞技场中表现出色,还在编程、数学和科学基准测试中占据领先地位,特别是在难度极高的“Humanity’s Last Exam”测试中,相比OpenAI o3-mini提升了近5%,提升幅度达到34%。目前,该模型已支持100万tokens的上下文窗口,并计划扩展至200万tokens,以更好地处理海量数据集。

第三段

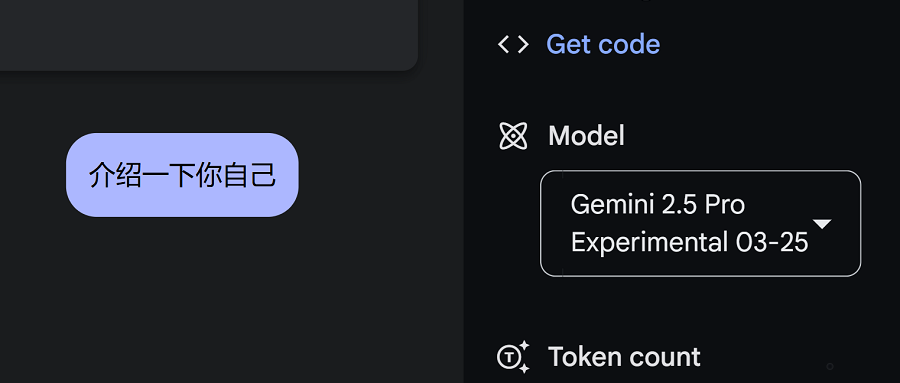

Gemini 2.5 Pro现已上线谷歌AI Studio平台,面向开发者提供服务,并将很快在谷歌的在线AI开发平台Vertex AI上线。普通用户若想体验这款新模型,需要拥有Gemini Advanced订阅账号。未来几周内,谷歌还将推出针对该模型的定价方案,允许用户使用2.5 Pro进行大规模商业应用。

第四段

谷歌DeepMind在其YouTube频道上发布了多个演示视频,展示了Gemini 2.5 Pro的强大编程能力及其与其他领域的结合。例如,它能够根据简单的指令生成p5.js中的曼德博集合可视化图表,展现出优秀的数学、编程和可视化能力。此外,Gemini 2.5 Pro还可以根据提示词创建互动式图表,例如将过去几十年的人均GDP数据与健康数据结合,揭示财富与健康之间的关系。

第五段

在游戏开发方面,Gemini 2.5 Pro同样表现出色。例如,它能够在指定编程语言的情况下生成兼具审美和可玩性的游戏。以下展示的一个恐龙小游戏风格与Chrome自带的游戏非常相似。

第六段

谷歌表示,Gemini 2.5 Pro在需要高级推理能力的基准测试中取得了最佳成绩,包括GPQA和AIME 2025。在“Humanity’s Last Exam”测试中,它获得了18.8%的最佳得分,且未使用任何工具或消耗大量token的计算技巧。这一测试集由数百位专家设计,涵盖了前沿深奥的知识和推理。

第七段

Gemini 2.5 Pro在高级编程能力方面也实现了显著提升,尤其是在创建美观的Web应用和智能体编程方面表现突出。同时,它擅长代码转换与编辑任务。尽管如此,在行业标准的智能体编程评估基准SWE-bench verified上,其得分仍低于Claude 3.7 Sonnet。

第八段

与Gemini模型家族的其他成员一样,Gemini 2.5 Pro具备原生多模态处理能力和超长上下文窗口。目前,它支持100万tokens的上下文窗口,并计划升级至200万tokens,从而能够解析海量数据集,处理来自文本、音频、图像、视频甚至完整代码库等多元信息源的复杂问题。

结语

Gemini 2.5 Pro的发布紧随DeepSeek-V3新版本之后不到30小时。谷歌和DeepSeek都选择了提升模型在编程、审美和数学等方面的能力,并将其作为亮点重点展示。AI编程能力的提升不仅能让普通用户直观感受到变化,还能在生产场景中带来显著效益。这一领域有望在未来成为各大模型厂商竞争的核心方向。

智东西【阅读原文】

智东西【阅读原文】